Ein Datacenter beinhaltet IT-Hardware (wie Server, riesiger Speicher, Netzwerk-Geräte und Racks) und die umgebende System-Infrastruktur mit dem Gebäude, Klimatisierung, Stromversorgung und schnellen Internet-Anbindungen. Betreiber eines Datacenters vermieten Unternehmen die Infrastruktur, damit diese im Datacenter ihre eigenen Server betreiben können. Zu den typischen Service-Leistungen eines Datacenter-Betreibers gehören hoch performante Anbindungen an Energie und Kommunikation, leistungsfähige Stromleitungen, Ausfallsicherheit und Redundanz bei Strom und effizienter Kühlungstechnik, höchste Verfügbarkeit bei der ganzen Infrastruktur, gute Isolierung des Gebäudes und hohe, mehrstufige physische Sicherheit.

Der Datacenter-Betreiber übernimmt somit die Verantwortung für die physische Sicherheit und Verfügbarkeit der Unternehmens-IT.

In der Vergangenheit betrieben Unternehmen häufig ihre eigenen Rechenzentren, was aber angesichts des hohen Stromverbrauchs der nicht ökologisch optimierten Rechenzentren zu hohen Kosten führt. Aktuell gehen viele Unternehmen daher dazu über, ihr Rechenzentrum auszulagern und Anwendungen in der Cloud zu betreiben.

Die Stromkosten eines Datacenters setzen sich aus zwei Kostenblöcken zusammen: Dem Verbrauch der IT-Systeme (Server, Storage und Netzwerk) und den restlichen Systemen der Gebäudetechnik (hauptsächlich Kühlung und Gebäudestrom).

Der entscheidende Faktor ist dabei die Power Usage Effectiveness (PUE), die beschreibt, wie gut das Datacenter den Strom in Rechenleistung umsetzt und wie viel für Kühlung und Gebäudemanagement aufgewendet wird. Je höher der Stromverbrauch und je ineffizienter der PUE, umso höher fallen die Kosten für den Rechenzentrumsbetrieb aus.

Jedes Kilowatt an Systemleistung in einem Datacenter mit schlechtem PUE-Wert kostet Geld ohne Gegenwert. Viele inhouse-Rechenzentren haben einen PUE von über 2. Damit kostet der Betrieb doppelt so viel, wie in einem ökologisch konzipierten Datacenter. Dazu kommen stetig neue Vorschriften zur Energieeffizienz. Betreiber eines Rechenzentrums mit einem PUE über 2 sollten über eine Zusammenarbeit mit einem externen RZ-Betreiber nachdenken.

Manche Unternehmen können aus technischen, regulatorischen oder Sicherheitsgründen ihre Anwendungen nicht in die Cloud verlagern. Ein Aufrüsten oder Modernisieren des eigenen Rechenzentrums erscheint aber häufig nicht wirtschaftlich und ist mit grossen Aufwänden für Personal und Technik verbunden.

Eine Lösung dafür ist die Nutzung eines Colocation-Datacenters. Dies sind externe Rechenzentren, in denen sich ein Unternehmen Gebäude-Infrastruktur wie Fläche, Stromversorgung, Kühlung und schnelle Internetanbindung mietet, um darin die eigenen IT-Systeme zu betreiben. Sie sind durch schnelle Glasfaser-Datenleitungen optimal an das eigene Unternehmen und ans Internet angebunden, räumlich aber vom Unternehmensstandort entkoppelt.

Der Vorteil für Unternehmen ist, dass sie kein eigenes Rechenzentrum unterhalten müssen, aber dennoch die eigenen IT-Systeme weiter betreiben können. Das bietet etliche Kostenvorteile, weil die Gesamtkosten eines Datacenters auf alle Nutzer eines Colocation-Datacenters verteilt werden. Um das Thema Sicherheit und Redundanz kümmert sich der Betreiber des Colocation-Datacenters.

Üblicherweise sind Colocation-Datacenter in räumlicher Nähe zum Unternehmensstandort zu finden, sodass die eigenen Techniker vor Ort Wartungsarbeiten an den IT-Systemen vornehmen können. Viele Anbieter von Colocation-Datacentern bieten ihren Kunden aber auch Hands-&-Eyes-Services, also Wartungstätigkeiten als Dienstleistung an (sogenannte Managed Colocation-Datacenter), welche den Einsatz des eigenen Personals im Datacenter vor Ort reduziert.

Weiter Kostenvorteile entstehen dadurch, dass Unternehmen die Miete des Colocation-Datacenters direkt als laufende Kosten verbuchen können (OPEX) und somit keine lange Abschreibung (CAPEX) nötig ist. Ausserdem kann die IT-Hardware aus dem bestehenden Rechenzentrum migriert und damit weiter genutzt werden. Grössere Investitionen in Hardware-Infrastruktur ist somit nicht oder nur im geringen Masse nötig.

Das Home-Office als Arbeitsplatz hat Pandemie-bedingt einen enormen Zulauf erlebt. 80% der Unternehmen in der Schweiz haben Home-Office für ihre Mitarbeitenden angeordnet und 67% haben die digitale Kommunikation forciert. Dieser Trend spiegelt sich auch in den Ausgaben der Unternehmen für ihre IT-Infrastruktur wider (Quelle: MSM Research).

Allerdings gibt es eine grosse Planungsunsicherheit, wie es in 2021 und 2022 weiter geht. Zu erwarten ist, dass den ICT-Markt in den nächsten beiden Jahren ein gewisser Nachholbedarf kennzeichnet, der sich aber hauptsächlich im Bereich Services und Outsourcing bewegen wird. Haben laut MSM Research 2017 noch 57% der Unternehmen ihre IT selbst gehostet, werden es 2022 nur noch 28% sein. 39% werden dafür Public-Cloud-Dienste und 33% auf Private-Cloud und externe Datacenter setzen.

Der Anteil der Unternehmen, die überhaupt keine ICT-Infrastruktur nach aussen verlagert, beträgt nur noch 14%.

Den grössten Shift in SaaS- und Cloud-Lösung gibt es für Software im Bereich Office/SharePoint/Exchange: Hatten Schweizer Unternehmen diesen Bereich im Jahr 2020 bereits zu 50% ausgelagert, so wird das sich bis 2022 auf 76% steigern. Auch in anderen Bereichen wie ERP, CRM, Business Analytics und EMC wachsen die Anteile um 60% bis 90%.

Getrieben werden die Entwicklungen zusätzlich durch einen starken Home-Office-Trend, der auch nach der Pandemie anhalten wird. Viele Unternehmen betrachten diesen Wandel als Chance. 80% sehen dadurch eine höhere Attraktivität der Arbeitsplätze (insbesondere auch für neue Fachkräfte, die schwer zu bekommen sind), 63% gefällt die Steigerung von Flexibilität, Innovation und Reaktionszeiten für Home-Office-Mitarbeiter.

Hinzu kommen geringere Reisekosten, eine Verbesserung der Ökobilanz durch wenige Fahrten zum Arbeitsplatz, geringere Standort- und Parkplatzkosten und schnellere Abstimmungen im Team durch Ad-hoc-Online-Konferenzen.

Diese Umwälzungen erzwingen einen Strukturwandel bei der ICT-Infrastruktur. Unternehmen brauchen die Cloud und leistungsfähige Datacenter, die über eine performante Anbindung, hohe Redundanzen und aktuelle Sicherheitsmechanismen verfügen. Viele Unternehmen mit einer rapide wachsenden Zahl an Home-Office-Mitarbeitern haben schnell erkannt, dass eine simple VPN-Anbindung an das interne Rechenzentrum relativ langsam und teuer ist.

Im Trend sind ausserdem Edge-Datacenter, die Kunden lokal mit Private-Cloud-Lösungen unterstützen: Lokale und zeitkritische Applikationen für IoT, Visualisierungen, Real-Time-Anwendungen und Augmented Reality erfordern möglichst kurze Latenzen. Möglich machen dies Edge-Datacenter, die physisch nah dort positioniert werden, wo grosse Datenmengen entstehen. So können sie flexibel und in Echtzeit Daten verarbeiten und punkten mit kurzen Latenzzeiten und persönlichen Service.

Die Schweiz – insbesondere mit den Regionen Zürich und Genf – gehört in Europa bereits zu den beliebtesten Datacenter-Standorten. Zürich liegt nach London, Frankfurt, Amsterdam, Paris und Dublin auf Platz sechs. Während in Frankfurt und Amsterdam erst jüngst die Verwaltungen aus Energieknappheitsgründen regulierend eingreifen mussten, um das Wachstum zu steuern, sind die Voraussetzungen in der Schweiz für den Ausbau von Datacenter nach wie vor hervorragend.

Zum einen hat die Schweiz hohe Datenschutzrichtlinien, die aber unabhängig von der DSGVO sind und Unternehmen grosse Rechtssicherheit bieten. Zum anderen bieten viele Kantone eine schnelle Glasfaseranbindung an schnelle Internet-Knotenpunkte (wie Zürich) und genug Kapazitäten für den grossen Strombedarf von Rechenzentren. Auch grosse Hyperscaler wie Google, Microsoft und Amazon bauen in der Schweiz ihre Kapazitäten aus, um ihren Kunden ortsnah schnelle Anbindungen anbieten zu können. Kurze Latenzzeiten und hohe Energieeffizienz sind dabei kritische Grössen, die Datacenter in der Schweiz problemlos garantieren können.

Der grösste Zuwachs erfolgt über Unternehmen aus dem Finanzsektor, Fin-Techs und international agierenden Schweizer Unternehmen, die ihre IT zunehmend in die Cloud und Datacenter verlagern. Aktuell sind ca. 19% der Rechenzentren-Kapazitäten in der Schweiz noch frei, weitere Projekte sind allerdings schon in Bau und Planung. Dabei gewinnen Rechenzentren in den einzelnen Regionen aufgrund der Nähe zu ihren Kunden laufend an Bedeutung.

Die Verlagerung von Anwendungen, Daten und Datenverarbeitung in die Cloud hat für Unternehmen häufig viele Vorteile. Es gibt jedoch etliche Anwendungsfälle, in der die Latenzzeiten und Übertragungsraten eher für den Einsatz eines externen Rechenzentrums sprechen. Dies ist dann der Fall, wenn schwankende Datenraten über das Internet und grössere Latenzzeiten bei der Verarbeitung von grösseren Datenmengen zu viel Zeit kosten:

Erst die direkte Anbindung der jeweiligen IT-Infrastruktur über eine eigene Leitung zum Datacenter garantiert die kurzen Reaktionszeiten, die für zeitkritische Anwendungen wesentlich sind.

Darüber hinaus hat ein Unternehmen in einem Colocation-Datacenter weiterhin die volle Kontrolle über ihre eigenen Server und IT-Hardware und kann bereits installierte IT-Infrastruktur weiternutzen. Auch Software, für die es noch keinen adäquaten Ersatz in der Cloud gibt, kann so weiterhin effizient betrieben werden. Die Verlagerung der IT in ein Datacenter kann somit ein erster Schritt in Richtung Hybrid Cloud sein.

Die Virtualisierung von Hardware macht nicht bei Servern halt: Sie setzt sich natürlich auch bei intelligenten Netzwerken in Form von Software-Defined-Networks (SDN) und Network Function Virtualization (NFV) fort. Trotz aller Virtualisierung müssen aber letztlich alle Daten noch über physische Leitungen zwischen Servern, Switches und anderer Netzwerk-Hardware transportiert werden. Die Architektur des Netzwerks in einem Datacenter spielt dabei eine wichtige Rolle. Da spätere Änderungen an der Netzwerk-Architektur grosse Kosten nach sich ziehen, ist es sinnvoll, sich zu Beginn Gedanken über die Nutzung des

Netzwerks zu machen.

Das klassische Datacenter-Netzwerk hat drei Schichten:

Alle Access-Layer-Switches in einem Aggregation Layer bilden ein eigenes VLAN, innerhalb dessen virtualisierte Server beliebig verschoben werden können, ohne IP-Adressen oder Default-Gateways ändern zu müssen.

Klassischerweise gab es in Datacentern bisher viel Nord-Süd-Traffic, weil Client-Anwendungen Daten angefordert, diese nach unten an einen Server weitergereicht und die Antworten wieder nach oben zurück und an den Client transferiert wurden. Hierbei kommt das Spanning-Tree-Protocol (STP) zum Einsatz. Ein direkter Datenaustausch zwischen den Aggregation Switches findet nicht statt und ist auch selten nötig (dann läuft er über die Core-Switches).

Moderne Software-Architekturen erfordern eine andere Netzwerk-Struktur. Sie nutzen mehrere virtuelle Server gleichzeitig, um eine Aufgabe zu erledigen und vernetzten mehrere Cloud-Anwendungen untereinander, die nicht alle im gleichen Aggregation Layer liegen. Virtualisierungsplattformen wie Hadoop verteilen hunderte virtuelle Server, die alle parallel arbeiten und Daten austauschen. Das führt zu einem grösseren sogenannten Ost-West-Traffic und erfordert eine gänzlich andere Netzwerk-Architektur und leistungsfähigere Aggregation- und Core-Switches, um den steigenden Traffic im Datacenter zu bewältigen.

Laut Cisco ist bereits heute 77% des Datacenters interner Traffic (Ost-West). Hinzu kommt Datacenter-zu-Datacenter-Verkehr für Redundanz und Backup und nur noch 14% ist Netzwerk-Traffic, den Clients ausserhalb des Rechenzentrums verursachen.

Für die Aussenanbindung ist es wichtig, dass ein Datacenter über einen eigenen hervorragenden Backbone verfügt und dort Direct-Connects und Peerings zu anderen Providern anbietet.

Anbieter von (Colocation-)Datacenter sorgen vor allem für Gebäude-, Brand- und Zugangskontrollschutz, also die physische Sicherheit und garantieren den 99,999-prozentigen Betrieb. Die IT-Sicherheit der eigenen Server-, Security- und Netzwerk-Infrastruktur verbleibt in der Verantwortung des Kunden, der die IT-Systeme im Datacenter betreibt.

Zu den wichtigsten physischen Sicherheitsmassnahmen eines Datacenters zählen:

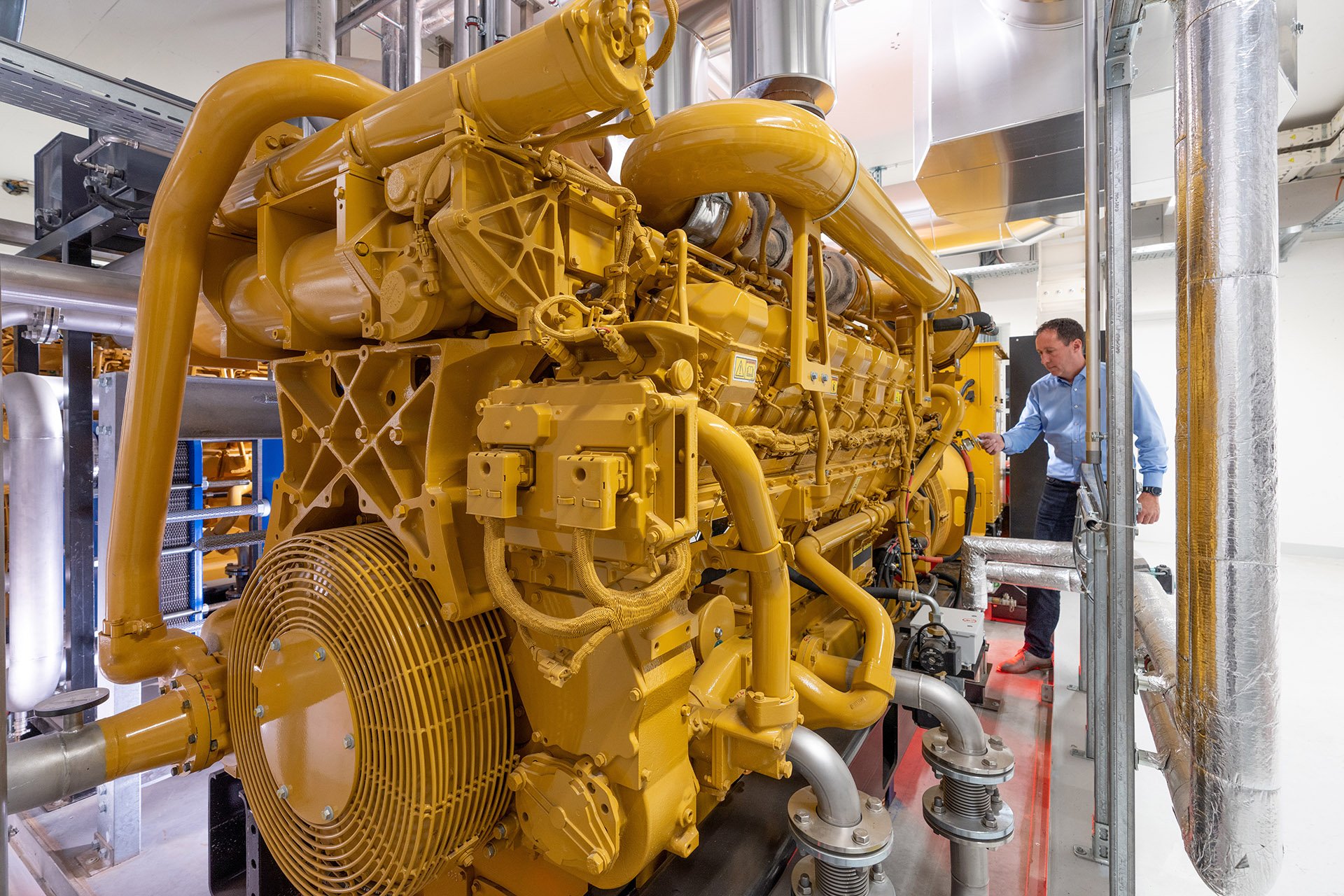

Zu den wichtigsten technischen Massnahmen eines Datacenter zählen:

Darüber hinaus ist es wichtig, dass das Sicherheitspersonal des Datacenters nur dann dort arbeiten darf, wenn es einem ausführlichen Sicherheitscheck unterzogen wurde und zahlreiche, einsatzspezifische Trainingsmassnahmen durchlaufen hat. Lokale Feuerwehren und Sicherheitsbehörden werden bei Ortsbegehungen auf die Besonderheiten der Anlage hingewiesen und können sich so im Einsatzfall bestmöglich orientieren und eingreifen.

Ausserdem sollte ein Datacenter-Betreiber durch Zertifizierungen gemäss ISO 27001 und ISO 22301 mit regelmässigen externen Audits nachweisen, dass er das ganzheitliche Betriebs- und Sicherheitskonzept korrekt umsetzt.

Rechenzentren sind grosse Stromverbraucher – was sich auf die Ökologie und den eigenen Geldbeutel auswirkt. Es lohnt sich also aus mehreren Gründen, den Strom möglichst effizient zu nutzen.

Da die Stromkosten die grössten Kosten beim Betrieb eines Rechenzentrums sind, ist der PUE-Wert für Kunden eine wichtige Grösse, denn sie bezahlen durch die Miete des Datacenters diese «Stromnebenkosten» mit.

Datacenter unterscheiden sich deutlich darin,

Häufig sind betriebsinterne Datacenter schlicht zu gross dimensioniert. Das führt dazu, dass zu grosse Luftmengen umgewälzt werden. Hier helfen Raum-in-Raum-Lösungen, um die Mengen zu begrenzen. Ebenso sind die klare Trennung von warmer und kalter Luft wichtig, wie auch die Einhausung von Kalt- und Warmwasserkreisläufen. Zur Senkung der Kühlkosten kann auch die Umgebungsluft («freie Kühlung») und – falls erlaubt – das Grundwasser herangezogen werden.

Eine deutliche Senkung der Stromnebenkosten gelingt nur durch ein abgestimmtes Konzept aller Massnahmen und einem kontinuierlichen Monitoring, das den Strombedarf des Datacenters und die IT-Last in Beziehung setzt.

Ab einem PUE von 2 sollte eine Ablösung des Rechenzentrums und eine Auslagerung in ein ökologischeres Rechenzentrum ins Auge gefasst werden. Die Kosten für den Betrieb eines Datacenters mit PUE 2 und mehr sind deutlich zu hoch.

Die Einstufung von Rechenzentren in Tier-Klassen gibt den Kunden eine einfache Möglichkeit, die Ausfallsicherheit und mögliche Ausfallzeiten pro Jahr abzuschätzen. Sie legt fest, welche technischen Eigenschaften und Redundanzen es besitzen muss, um eine bestimmte Einstufung zu erhalten. Diese Kriterien sind in der ISO 2701 und EU-Norm 60001 festgelegt.

Ein Tier-I-Rechenzentrum besitzt keine redundanten Systeme. Es gibt also keine Ersatzsysteme für Strom, Internet und Klimatisierung, was bei Reparaturen oder Instandhaltung zu Ausfällen führt. Damit ist es nicht fehlertolerant. Diese Form des Rechenzentrums findet man nur noch in Unternehmen mit alter IT-Infrastruktur.

In einem Tier II-Rechenzentrum gibt es redundant ausgelegte Komponenten für Stromversorgung und Kühlungssysteme, wie zusätzliche Kühleinheiten, Pumpen, Generatoren und USV-Module. Server sind aber nicht redundant ausgelegt, auch die Internet-Anbindung ist nur einfach.

Am häufigsten sind Tier-III-Rechenzentren anzutreffen. Sie sind fehlertolerant und wartungsfreundlich, weil alle wesentlichen Komponenten redundant vorhanden sind. Dazu gehören auch Server und die Internet-Anbindung über aktive und passive Verbindungswege. Gebäudebereiche haben ebenfalls mehrfach ausgelegte Strom- und Kühlungssysteme und sind durch Brandabschnitte voneinander getrennt. Der besondere Unterschied zu Tier II ist, dass in einem Tier-III-Rechenzentrum Wartungsarbeiten ohne Unterbrechung des laufenden Betriebs vorgenommen werden können.

Die höchste Klasse ist Tier IV – quasi die Premium-Variante mit höchster Redundanz und Ausfallsicherheit, aber auch entsprechenden Kosten. In diesen Datacentern verfügen alle Systemelemente (Netzwerk, Strom, Kühlsysteme, Server) über Automatismen, die bei funktionellen Anomalien selbstständig Reaktions- und Abwehrmechanismen auslösen, um einen Ausfall zu verhindern. Damit gibt es in Tier IV-Rechenzentren keine Elemente mehr, die einen Totalausfall herbeiführen könnten (kein Single Point of Failure, SPOF). Sie sind oft auch im Katastrophenfall noch einsatzfähig.

Rechenzentren benötigen viel Strom, in der Schweiz sind es nach einer aktuellen Studie bereits 3,6% des gesamten Strombedarfs. Viele Kantone haben aus ökologischen Erwägungen heraus Energieeffizienz-Gesetze verabschiedet, nach denen der jährliche Stromverbrauch kontinuierlich zu senken ist. Der Bundesrat hat darüber hinaus die Energiestrategie 2050 verabschiedet.

Green-IT, also der sorgsame Umgang mit der Natur beim Einsatz von IT, ist seit Jahren ein grosses Thema für Unternehmen. Hierbei spielt der Einsatz von Materialien, aber natürlich auch und insbesondere die Energieeffizienz eine grosse Rolle.

Vergleicht man interne Rechenzentren in Unternehmen mit Colocation-Datacentern, wird klar, warum unter ökologischen Gesichtspunkten die internen Datacenter schlechter abschneiden:

Jedes Kilowatt an Systemleistung in einem Rechenzentrum kostet den Kunden Geld, ohne dass er eine Gegenleistung dafür erhält. Je grösser der PUE-Wert, um so mehr Geld wird sinnlos verbrannt und die Umwelt unnötig belastet. Unternehmen können mit der Auslagerung ihrer IT in ein Colocation-Datacenter ihren ökologischen Fussabdruck massiv verbessern und gleichzeitig ihre Betriebskosten deutlich senken.

ISO 50001: Die internationale Norm ISO 50001 liefert Richtlinien für ein funktionierendes Energiemanagementsystem. Dieses dient dazu, die Energieeffizienz eines Unternehmens stetig und nachhaltig zu verbessern. Eine entsprechende internationale Zertifizierung weist nach, dass die Norm erfolgreich umgesetzt wird und zeigt Kunden, dass ein Colocation-Datacenter effizient betrieben wird.

Das digitale Herzstück eines Unternehmens, das Datacenter, erfordert eine lückenlose Überwachung und Monitoring aller Systeme, inklusive des Gebäudes, der Server und der darauf laufenden Anwendungen.

Ein zeitgemässes Monitoring beschränkt sich deshalb nicht nur auf die IT-Systeme, sondern bindet in das Monitoring auch die Gebäude-Systeme, Temperaturüberwachung, Kühlsysteme, Sicherheitszugänge und vieles mehr ein. Es prüft auch die installierten Software-Anwendungen und deren Reaktionsfähigkeit.

Ziel ist es, über ein einheitliches System alle Aspekte permanent, 24/7/365, zu überwachen, Anomalien vorzeitig festzustellen und auch Auswertungsmöglichkeiten für mögliche Optimierungen zu schaffen. Das Monitoring-System muss dabei möglichst flexibel zu handhaben sein, um auf die individuellen Bedürfnisse des Kunden zugeschnittene Dashboards zu erstellen und Automatisierungen einzurichten, die auf bestimmte Konstellationen sofort reagieren. Dazu gehört auch ein ausgefeiltes Alerting-System, das schnell auf irreguläres Verhalten und Angriffe reagiert.

Darüber hinaus muss das Monitoring-System auch in der Lage sein, Daten verschiedenster Rechner- und Steuerungssysteme modular einzubinden und zu verarbeiten. Dazu gehören Schnittstellen zu IT-System-Anbietern wie Dell, HP, Lenovo und Netzwerk-Ausstattern wie Cisco oder Huawei.

Ausserdem erstellen moderne Monitoring-Systeme auch passiv (also ohne installierte Software-Agenten) ein vollständiges Inventar aller Systeme. Sie können anschliessend auf fehlende Patches von Software und Schwachstellen hinweisen. Durch eine permanente Überwachung der Netzwerk-Daten entdecken Sie ebenfalls neu auftauchende Systeme im Netzwerk oder plötzliche Veränderungen im Datenstromverhalten.

Ein Datacenter beherbergt in der Regel alle wichtigen IT-Systeme, die für das Unternehmen für den Betrieb unabdingbar notwendig sind. Sie sollten im besten Fall nie ausfallen und eine 100%ige Verfügbarkeit haben. Natürlich hält nichts ewig, auch nicht in der IT. Ausfälle einzelner Systeme oder erfolgreiche Hackerangriffe werden also vorkommen – genauso wie Naturkatastrophen wie Überschwemmungen, Hagelstürme oder Feuer sich nicht 100%ig ausschliessen lassen.

Beim Betrieb eines Datacenters ist es daher wichtig, auf solche Ereignisse vorbereitet zu sein, um einen unterbrechungsfreien Betrieb (Stichwort: Business Continuity) zu gewährleisten. Falls das nicht gelingt, muss es Pläne für ein Disaster Recovery geben, um auch bei schweren Störungen schnell wieder Daten restaurieren und den Betrieb aufnehmen zu können.

In der Regel gelingt eine Absicherung gegen schwere Störung nur durch Redundanz und Backups, am besten örtlich getrennt in einem zweiten Datacenter, das bei Störungen nahtlos übernehmen kann.

Wichtig bei der Planung der Redundanzen und Disaster-Recovery-Vorfällen: Sie müssen in unregelmässigen Abständen getestet und geübt werden, damit im Ernstfall jeder weiss, was zu tun und welche Schritte unternommen werden müssen. Dies gilt sowohl für «kleine» Ausfälle von einzelnen Servern bis hin zu Bränden, dem Ausfall einer Internet-Leitung oder der Kühlung.

Im Falle des Zurückspielens von Daten aus Backups muss ausserdem im Vorfeld schon geklärt sein, wie gross die Zeitspanne zwischen einzelnen Backups sein darf und welchen Datenverlust ein Unternehmen bereit ist, im Ernstfall hinzunehmen.

Heutzutage lassen sich alle Teile eines Datacenters komplett virtualisieren. Dies gilt nicht nur für die Server-Hardware, sondern auch für Speicherkomponenten (Storage) und das Netzwerk. Bei entsprechender Planung und Umsetzung lässt sich ein komplettes Datacenter virtualisieren und in die Cloud migrieren.

Ein solches virtuelles Cloud-Datacenter (VDC genannt) hat für Unternehmen diverse Vorteile:

Ein virtuelles Cloud-Datacenter verbindet die Flexibilität und Kostenvorteile einer Cloud-Lösung mit der Sicherheit und Kontrolle eines eigenen Datacenters.

Wenn Sie Ihr Datacenter migrieren wollen, gilt es die Risiken, die Migrationskosten und die Einsparpotenziale gegeneinander abzuwägen. Dabei stellt sich natürlich die Frage, welche Kosten eine Migration verursacht.

Zuerst müssen Sie entscheiden, ob bei der Migration auch Modernisierungsvorhaben umzusetzen sind. Eine reine Migration ohne grössere Veränderungen an der IT-Infrastruktur lässt sich leichter abschätzen und umsetzen. Sie birgt ausserdem weniger Risiken durch den Umzug.

Zu den Aufwänden einer Migration gehören:

Je nach Grösse und Umfang des alten Datacenters sind das fünf- oder sechsstellige Summen.

Dem gegenüber stehen allerdings diverse Kosteneinsparungen, die den Umzug in der Regel in wenigen Jahren amortisieren:

Sowohl bei der Migration des eigenen Datacenter in ein Colocation-Datacenter mit der dazu notwendigen Planung und Analyse des Ist-Zustandes steht Ihnen Netrics mit seinem umfangreichen Know-how zur Seite. Wir begleiten Sie bei der Analyse der bestehenden IT-Infrastruktur, der Evaluation, der Migration und natürlich dem Betrieb Ihres Colocation-Datacenters. Auf Wunsch kümmern wir uns um das Recycling alter Geräte, unterstützen bei der Umnutzung der alten Rechenzentrumsräume und übernehmen eventuell ihre Spezialisten.

Arbeiten Sie mit einem Colocation-Anbieter in Ihrer Nähe zusammen und bringen Sie dort Ihre neuen Server in einem Rack unter. Sie können so nach und nach weiter ausbauen, ohne an die Grenzen zu stossen. Dank guter Vernetzung des externen Datacenters mit Ihrem Standort ist kein Unterschied für sie spürbar.

Der grösste Kostentreiber in einem Rechenzentrum ist der Stromverbrauch: 50% des Stromverbrauchs fallen für die Kälteerzeugung, 20% für die Luftführung, 15% für die Kaltwasserverteilung an. In geteilten Provider-Datacenter-Infrastrukturen können diese System-Kosten auf viele Unternehmen verteilt werden, womit Sie günstiger fahren. Zudem sind unsere Datacenter von Grund auf ökologisch konzipiert, was auch den Stromverbrauch und damit die Kosten senkt.

Erfahren Sie mehr in unserem Artikel «Altes Rechenzentrum: Sanieren oder Outsourcen?»

Ein Rechenzentrum muss ökologisch konzipiert und gebaut werden, denn jedes Kilowatt an Systemleistung in einem Datacenter mit schlechtem PUE-Wert kostet den Kunden Geld – ohne Gegenwert. Viele kleinere, ältere Rechenzentren haben einen PUE-Wert von über 2. Damit kostet der Betrieb doppelt so viel wie in einem ökologisch konzipierten Datacenter. Hinzu kommen neue Vorschriften hinsichtlich der Energieeffizienz. Betreiber eines Rechenzentrums, dessen PUE-Wert um 2 liegt, sollten über eine Zusammenarbeit mit einem RZ-Betreiber nachdenken.

Die Digitalisierung ist neben vielen Vorteilen auch für einen beträchtlichen Anteil des weltweiten CO2-Ausstosses verantwortlich und belastet so das Klima. Umso wichtiger ist es, energieintensive IT-Infrastruktur so umweltschonend wie möglich zu betreiben. Die Rechenzentren von Netrics setzen auf eine stufenweise, modulare Architektur zur maximalen Optimierung der Energieeffizienz (PUE). Neben der CO2-armen Produktion von Kälte durch Freecooling – und höherer Systemtemperatur wird die produzierte Abwärme von naheliegenden Bezügern genutzt. Durch den Konsum von Strom ausschliesslich aus erneuerbarer Energie können Rechenzentren heute CO2-neutral betrieben werden. Lagern Sie Ihre Infrastruktur in unsere Rechenzentren aus – der Umwelt zuliebe!

IoT, AI, Big Data, Augmented Reality und andere innovative Technologien erfordern eine extrem hohe Rechenzentrumsleistung und kurze Latenz, um die Applikationen benutzerfreundlich wiederzugeben.

Wenn Sie Ihre Daten in ein externes Datacenter in Ihrer Nähe auslagern, können Sie von den High-Performance-Installationen des Providers profitieren und stellen eine rasend schnelle Verbindung für gute Performance sicher.

Moderne Datacenter sind von Grund auf ökologisch gebaut. So wird beispielsweise Ihre Abwärme in nahegelegenen Gebäuden genutzt, die Produktion von Kälte erfolgt durch Freiluft und Kaltgänge sind von Warmgängen getrennt. Dies ist in bestehenden Infrastrukturen enorm schwierig zu realisieren. Zudem ist der grösste Kostentreiber der Strom, grösstenteils durch die Kälteerzeugung, Luftführung und durch Verluste. In einem professionellen Datacenter von entsprechender Grösse werden diese Infrastrukturkosten optimiert und auf viele Kunden und Fläche geteilt. So sind ganz andere Preisstrukturen möglich. In die Modernisierung eines veralteten Datacenters zu investieren, ist nicht mehr zeitgemäss. Nutzen Sie Ihren Raum um und lagern Sie Ihre Server in ein Datacenter in Ihrer Nähe aus. Ihr CFO wird sich über Ihre Kosteneinsparungen freuen.

On-Premises Rechenzentren bergen viele versteckte Kosten, die in unterschiedlichen Konten zu Buche schlagen, dazu zählen Raummiete, Strom, Personal, Server, Versicherung etc. Eine Gesamtkostenübersicht zu erstellen, ist meist nicht leicht.

Laden Sie unseren TCO-Rechner herunter und Sie erhalten in wenigen Minuten eine auf Basis von Richtwerten berechnete Gesamtkostenrechnung Ihres Datacenters im Vergleich zu einer Provider-Lösung.

Arbeiten Sie mit einem Datacenter- und Cloud-Dienstleister wie Netrics zusammen. Sie können Ihre bestehenden Server in unseren Datacentern weiter betreiben und nach und nach in die Cloud transferieren. Neue Anwendungen können Sie gleich in der Private oder Public Cloud starten – je nach Compliance-Anforderungen. Wir managen Ihre hybride Infrastruktur aus einer Hand.

Rechen- und Speicherkapazität kann heute einfach nach Bedarf als Service aus der Public Cloud bezogen werden. Jedoch eignen sich nach wie vor nicht alle Infrastrukturkomponenten und Anwendungen für eine Transition in die Cloud. Hier spielen häufig auch rechtliche Aspekte eine Rolle. Dennoch müssen Sie nicht weiterhin eine teure Rechenzentrums-Infrastruktur im eigenen Hause betreiben. In unseren hochmodernen Rechenzentren bieten wir Ihnen den idealen Standort für Ihre IT-Infrastruktur – vom einzelnen Rack bis zum privaten Raum. Darüber hinaus können Sie mit einer hybriden Lösung, bei der Services aus der Public Cloud mit Infrastruktur aus dem Rechenzentrum verbunden werden, das Beste aus beiden Welten nutzen.

Immer mehr IT-Infrastruktur wird in ein Rechenzentrum oder direkt in die Cloud migriert. Um die Kommunikation zwischen den Standorten, den Rechenzentren oder der Cloud gewährleisten zu können, braucht es leistungsstarke und stabile Verbindungen. Häufig bestehen bereits langjährige Beziehungen und Verträge mit entsprechenden Anbietern. Unsere 6 Rechenzentren in 3 Regionen in der Schweiz sind Carrier-neutral. Wir kooperieren mit über 40 Anbietern und helfen Ihnen, Ihre bestehenden Verbindungen weiter nutzen zu können. Oder wir helfen Ihnen, die bestmögliche Auswahl an Leitungen, IP-Transit, Peering-Vereinbarungen, Dark Fiber oder Anbindungen an die Public Cloud für eine Erweiterung zu treffen.

Erstellen Sie Ihr Backup in einem externen Datacenter und stellen Sie damit georedundante Datenhaltung sicher. Kontaktieren Sie uns und wir konzipieren mit Ihnen den für Sie passenden Colocation-Setup.

Strenge Auflagen aus den Baugesetzgebungen und Vorschriften bezüglich ökologischer Aspekte machen den Bau eines Rechenzentrums in vielen Städten fast unmöglich oder sehr teuer. Das Verbauen von Klimasystemen oder umfangreiche Netzersatzanlagen mit Dieselgeneratoren sind oftmals verboten bzw. erfordern eine nur sehr schwer erhältliche Spezialbewilligung. Die Auflagen zur Energienutzung werden stetig strenger, wie die Energiestrategie 2050 zeigt. Nur von Grund auf ökologisch konzipierte und gebaute Datacenter erreichen gute Ökologiewerte (PUE). Zudem sind gemeinsam genutzte Anlagen viel ökologischer. In den externen Datacentern werden Stromkosten eingespart, dadurch sinken auch die Kosten für die Kunden, die diese Datacenter nutzen.

Ein Grund mehr für Unternehmen, die benötigten Rechenzentrumsleistungen auszulagern.

Ihre Server sind direkt an einem Hotspot angebunden und somit an der «Hauptader». Die Benutzer geniessen ein optimales Anwendererlebnis. Die Latenzzeiten, also die Zeit, die eine Information oder ein Datenpaket von der Quelle bis zum Ziel benötigt, sind beim Betrieb Ihrer IT-Lösung in einem externen Rechenzentrum mit hoch leistungsfähigem Netzwerk deutlich kürzer. Damit ist auch die erlebbare Performance (Ladezeiten, Seitenaufbau etc.) beim Anwender höher.

Ja. Die Georedundanz wird mit zwei oder mehr räumlich voneinander getrennten Netrics Rechenzentren in der Schweiz realisiert. Selbst im unwahrscheinlichen Fall eines Ausfalls von Komponenten oder gar eines gesamten Rechenzentrums stehen Ihre Daten und Anwendungen unterbrechungsfrei zur Verfügung. Ihre Business Continuity ist also jederzeit gewährleistet.

Verteilte Infrastrukturen an den verschiedensten Standorten im eigenen Unternehmen, im Rechenzentrum oder in der Cloud sind heute Alltag. Durch moderne Netzwerke lassen sich diese Standorte problemlos miteinander verbinden. Unsere 6 Rechenzentren sind Carrier-neutral. Mit über 40 Anbietern unterhalten wir entsprechende Beziehungen und realisieren so für Sie die bestmögliche Verbindung Ihrer Standorte mit Leitungen, IP-Transit, Optical Services, Dark Fiber und Peerings ab Datacenter. Für Anbindungen an die Public Cloud stehen Direktverbindungen zu den wichtigsten Anbietern wie Microsoft (ExpressRoute), Google und Amazon zur Verfügung.

Eine Datacenter-Migration ist eine logistische Herausforderung und gleicht einer Operation am offenen Herzen. Daten dürfen auf keinen Fall verloren gehen und häufig muss eine Migration mit minimalen Serviceunterbrüchen auskommen. Das erfahrene Datacenter-Migrationsteam von Netrics unterstützt Sie bei der Planung und Umsetzung Ihres Umzugs in eines unserer 6 Rechenzentren. Neben dem Fokus auf die Compliance und Sicherheit legen wir vor allem Wert auf Ihren Komfort. Sie wählen, bis zu welchem Grad wir Sie unterstützen sollen. Dies reicht von der Konzeption bis zum kompletten Datacenter-Umzug.

Netrics unterstützt Sie von der Beratung über die Migration bis zum Betrieb in unseren Rechenzentren – und darüber hinaus. Wir inspirieren Sie zu einer innovativen und sinnvollen Umnutzung des frei gewordenen Raumes. Zudem übernehmen wir das Recycling der nicht mehr benötigten Gerätschaften.

Und wir gehen noch einen Schritt weiter: Ihre bisherigen Datacenter-Mitarbeiter sind bei entsprechender Eignung im Team von Netrics willkommen. Auch das verstehen wir unter sozialer Verantwortung.

Trotz Digitalisierung und Möglichkeiten der Fernsteuerung können nach wie vor Szenarien eintreten, die eine physische Intervention vor Ort erfordern. Netrics bietet Ihnen in allen Rechenzentren den Hands & Eyes-Service. Dieser fungiert als verlängerter Arm ins Rechenzentrum und übernimmt Aufgaben wie Ein- und Ausbau, Austausch und Kontrolle von Hardware-Komponenten oder die Ausführung von Routinen zur Fehlerbehebung.

Die Anforderungen an die sichere Aufbewahrung von Infrastruktur und Daten steigen stetig. Digitale Werte müssen bestmöglich geschützt werden. Die 6 Rechenzentren von Netrics genügen höchsten Sicherheitsstandards und verfügen über die nötigen Zertifizierungen (ISO 27001, FINMA-konform). 5 Sicherheitszonen sorgen für maximale Sicherheit in und um die Rechenzentren. Der Netrics CISO (Chief Information und Security Officer) berät Sie gerne zu allen Sicherheitsbelangen und stimmt diese auf Ihre Anforderungen ab.

Als Kunde stehen Ihnen jederzeit Live-Daten aus unserem Datacenter zur Verfügung. Sie sind in Echtzeit exakt über Temperatur, Strom, Balance, Feuchtigkeit, Zutrittsstatus etc. informiert. Die Gegebenheiten im Rechenzentrum sind transparent und es findet ein professionelles Monitoring statt.

Hybride Szenarien, bei denen Services aus der Public Cloud mit Infrastruktur aus dem Rechenzentrum verbunden werden, sind heute an der Tagesordnung. Eine stabile und insbesondere performante Anbindung an die Public Cloud ist daher für das geforderte Anwendererlebnis unumgänglich. Mittels Cloud Connect unterstützen wir Sie bei der Anbindung des gewünschten Cloud-Anbieters. Netrics unterhält zu den wichtigsten Public Cloud-Anbietern wie Microsoft (ExpressRoute), Google und Amazon direkte Verbindungen und hilft Ihnen so, Ihre hybride Infrastruktur optimal zu nutzen.

Mit dem Hybrid Cloud Management sind Sie auf der sicheren Seite. Wir übernehmen das Management Ihrer Azure Public Cloud sowie den Betrieb Ihrer Applikationen in unseren Datacentern. Ein professionelles Monitoring zeigt uns den Status und gibt Hinweise auf Probleme, die möglicherweise in Zukunft auftreten könnten. Sie können also völlig beruhigt sein – Ihre Daten sind in professionellen Händen.

Eine Modernisierung und die Migration Ihrer IT in ein Netrics Rechenzentrum kann in unterschiedlicher Ausprägung erfolgen. Beispiele für drei unterschiedlich weitreichende Migrationsszenarien:

1. Move: Ihre bestehenden Server werden in eines der 6 Rechenzentren von Netrics umgezogen.

2. Lift: Ihre Daten und Applikationen werden in neue Server umgezogen, gewisse auf modernere Applikationen migriert, evtl. andere aus der Cloud bezogen (SaaS).

3. Shift: Ihre Applikationen werden komplett neu aufgebaut und in einem Netrics Rechenzentrum betrieben.

Netrics bietet mit dem «Move, lift & shift»-Ansatz die schrittweise und kontrollierte Transformation hin zu einer Hybrid Cloud. So übernehmen wird die Migration Ihrer bestehenden Infrastruktur in unser Datacenter und betreiben wiederum andere Applikationen in unserer Private Cloud sowie ausgewählte Anwendungen aus der Public Cloud.

Mehr zu «Rechenzentren: Selbst bauen oder mieten», lesen Sie in unserem Blogartikel.

Die Sicherheit Ihrer IT-Infrastruktur in einem Colocation-Datacenter hängt von mehreren Faktoren ab: Zum einen von der IT-Sicherheit ihrer eigenen IT, die Sie selbst im Colocation-Datacenter betreiben, zum anderen von der Infrastruktur eines Betreibers wie Netrics.

Zu unserem Sicherheitsportfolio gehören:

Nicht nur für Schweizer Unternehmen, sondern auch für international agierende Firmen ist ein Datacenter in der Schweiz sehr attraktiv.

Netrics als Partner ist dabei die beste Wahl, weil wir nicht nur topmoderne, hocheffiziente und sichere Datacenter an vier verschiedenen Standorten (Zürich, Basel, Biel, Solothurn) in der Schweiz betreiben, sondern auch ein umfangreiches Service- und Leistungsspektrum für unsere Kunden anbieten können. So können wir nicht nur Platz, Strom und Netzwerk-Anbindung zur Verfügung stellen, sondern auch weitreichende Serviceangebote zum Betrieb ihrer IT-Infrastruktur realisieren.

Als Fullservice-Datacenter-Betreiber unterstützten wir Sie ausserdem vollumfänglich bei der Planung und Migration Ihres Rechenzentrums in eines unserer Colocation-Datacenter und kümmern uns dabei auch um die Anbindung ihrer Firmen-IT an das Datacenter. Nicht zuletzt können Sie uns auch mit dem Recycling ihrer alten Anlagen beauftragen – ein Angebot, das viele Unternehmen zu schätzen wissen.

Unsere Datacenter arbeiten höchst effizient: Der Datacube in Münchenstein wurde wegen seines extrem niedrigen PUE-Wertes von 1,24 vom Förderprogramm PUEDA des Bundesamts für Energie BFE ausgezeichnet.

Ebenfalls eine Besonderheit: Wir unterhalten Beziehungen zu 40 Internet-Providern in der Schweiz, die eine schnelle Anbindung ans Internet per Glasfaser anbieten und können unseren Kunden daher herstellerunabhängig höchste Verfügbarkeit zu sehr attraktiven Konditionen anbieten, die eine maximale Internet-Verfügbarkeit garantiert. Ausgefallene Internet-Leitungen gehören damit der Vergangenheit an.

Wir legen ausserdem grossen Wert auf einen ökologischen Fussabdruck, verwenden Aussenluft und Grundwasserkühlung, um den Energieverbrauch der Gebäude zu senken und nutzen die Abwärme zur Beheizung naheliegender Gebäude. Mehr zum Thema Ökologie finden Sie im Beitrag «Warum Colocation umweltfreundlicher als der Betrieb eines eigenen Rechenzentrums ist».

Mit Industrie 4.0 und IoT hat ein grundsätzlicher Wandel in der produzierenden Industrie stattgefunden. Moderne Produktionsanlagen erzeugen heutzutage eine Unmenge an Daten, um eine effektive Steuerung zu gewährleisten und mögliche Ausfälle rechtzeitig zu erkennen und gegenzusteuern (Predictive Maintenance). Die Turbine eines modernen Verkehrsflugzeugs liefert beispielsweise 10 Terabyte in 30 Minuten.

Solche grossen Datenmengen lassen sich nicht ungefiltert in die Cloud schicken und dort in Echtzeit verarbeiten. Auch die Latenzzeiten für eine Echtzeitsteuerung wären dabei zu gross. Abhilfe schafft hier ein Edge-Datacenter von Netrics. Es wird möglichst nah an den Datenquellen platziert, um die grossen Datenmengen direkt auszuwerten, entsprechende Aktionen zu veranlassen und nur die Daten an die Cloud oder entfernte Datacenter weiterzuleiten, die dort benötigt werden. Die Steuerung des Datenstroms übernehmen spezielle Edge-Gateways. Diese Struktur garantiert kurze Latenz- und Reaktionszeiten.

Der Vorteil eines Edge-Datacenters von Netrics gegenüber einem eigenen Datacenter vor Ort ist, dass Sie sich als Unternehmen nicht um die Anbindung ans Internet, die gesetzlichen Vorgaben, Kühlung, Stromversorgung und das Thema «effizienter Betrieb» kümmern müssen. Mit einem Edge Datacenter erhalten Sie ein effizientes und hochperformantes Rechenzentrum für ihre Produktion, ohne es selbst betreiben zu müssen.

Der typische Anwendungsfall bei einer Migration Ihres Rechenzentrums in ein Colocation-Datacenter von Netrics ist, dass Sie ihre Server und IT-Hard- und Software weiterhin selbst betreuen – insbesondere, wenn das Colocation-Datacenter in der Nähe ihres Unternehmens steht.

Es kann aber sinnvoll sein, Teile des IT-Supports und IT-Managements an Netrics auszulagern, um sich so Wege, Personal und Kosten zu sparen. Dazu bieten wir sogenannte Managed Colocation Services an, von denen die meisten rund um die Uhr (24/7/365) zur Verfügung stehen. Dazu gehören:

Systemadministration – Das Installieren und Updaten von (Betriebssystem-)Software und Einspielen von Sicherheitspatches; Netzwerkfehlersuche; Neustarten von Systemen

Hardware-Tätigkeiten – Installieren von neuer Hardware oder Austausch bestehender Systeme; physisches Überprüfen von Storage und Netzwerk-Systemen (Hands & Eyes, Remote Hands Services)

Aktive Überwachung – Unser Monitoring kann ihre Server-Aktivitäten permanent überwachen und im Falle von Abweichungen sofort reagieren und Techniker mit dem Beheben der Probleme beauftragen.

Backup-Services – Wir übernehmen für Sie gerne auch das komplette Backup- und Disaster-Recovery-Management und stellen dafür High-Speed-Hardware und -Leitungen zur Verfügung.

Netzwerk-Management – Auf Wunsch übernehmen wir auch die komplette Netzwerkbetreuung ihrer Switches, VPN, Firewalls und Security-Devices, überwachen die Netzwerk-Aktivitäten und beheben aktiv Probleme wie zu hohe Auslastung, Packet-Loss oder Routing-Probleme.

Planung und Organisation – Datacenter Consulting, Plan, Build & Run: Wir unterstützen Sie in allen Phasen und Prozessen bei der Migration in Ihr neues Datacenter.

Das Outsourcing des eigenen Rechenzentrums ist neben technischen Aspekten vor allem auch eine Frage des Know-hows und des Vertrauens.

Netrics hat schon viele Unternehmen bei der erfolgreichen Migration begleitet. Unsere Kunden schätzen besonders den reibungslosen Übergang, den umfassenden Service, die hohe Sicherheit und niedrigen Betriebskosten. Das kontinuierliche Wachstum des Unternehmens zeigt, dass wir offensichtlich vieles richtig machen.

Setzen Sie deshalb beim Outsourcing ihrer IT-Infrastruktur auf Netrics. Sie profitieren von der sprichwörtlichen Schweizer Zuverlässigkeit, dem hohen Sicherheitsniveau und einem minimalen ökologischen Fussabdruck. Hinzu kommen die verlässlichen politischen Rahmenbedingungen und hohen Datenschutzvorgaben.

Sind Sie interessiert? Dann nehmen Sie Kontakt zu uns auf. Wir freuen uns darauf, ihre IT zu optimieren!

Netrics fokussiert sich als Partner für die digitale Transformation auf die Themen Cloud und Modern Workplace. Durch den gezielten Einsatz zukunftsweisender Technologien und unter Berücksichtigung der menschlichen Aspekte ermöglicht Netrics modernes, ortsunabhängiges und sicheres Arbeiten und kreiert so grossartige Erlebnisse für Mitarbeitende und Kunden.